当AI开始故意变差,真正的危险就降临了

还记得几年前人类第一次见到 AI 生图时的反应吗?

先是靠判断违背物理常识的“一眼假”,比如生成的手指个数不对又变形,生成的人类永远吃不好面条。

随着 AI 发生常识性错误在一点点减少,它又走向另一个“极端”,生成的人像皮肤太光滑、光线太扁平、构图太端正,乍一看像P过的影楼写真。“这不像是人拍的”,对此,我们还能发出经验主义的警觉。

猛一看很真实,细看太过完美光滑|APOB AI

但是,朋友们,在这个人机难辨的时代,任何识别经验都会被随时淘汰。

新的 AI 图像模型开始主动往“差一点”的方向走了。它们学会模仿手机摄影出现的不完美的质感:对比度不高、锐化过头、阴影被硬生生拉亮、构图带点随意,甚至有点糊。

也就是说,AI 不再追求生成“最好的照片”,而是试着生成“你会拍出来的那种照片”。而正是这些“瑕疵”,让图像突然变得可信了。

这个变化节点透露出一丝更加“危险”的气息,AI 正在学习如何显得不那么完美,就像人类一样。

AI:我装的

真实世界从来不是高清、完美、对称、干净的。我们之所以相信一张照片是真的,并不是因为它好看,而是因为它符合我们记录现实的方式。

早期的 AI 图像,它们最大的破绽是一种诡异的“完美”。图像每一颗像素都太滑、太亮、太干净了,就像是把“磨皮”开到最大后又抹了层油和蜡,人像宛如蜡像,不生动。

原因很简单,当你输入“一张桌子”,AI 会生成一个“在任何评判标准下都符合的结果”,它大概率是一张“教科书图”。而且,从数据来源来说,往往被反复标注和引用的图片都是这种“标准图”,模型早期的核心逻辑是在真实中“求平均值”,AI 会调取它数据库里见过的几十亿张桌子,然后取一个中间值,那种随手一拍家里的脏乱桌子图在这种巨量的平均之下被“稀释”了。

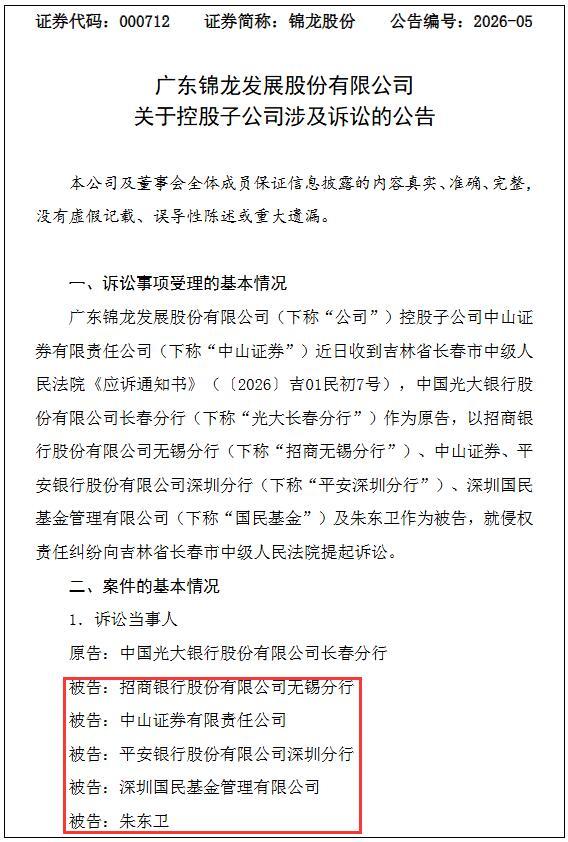

去掉“油蜡感”是 AI 生图拟真的重点|X

而今天训练模型的人在教 AI “搞砸”。

以最近 Gemini 里集成的 Nano Banana 为例。它生成的图像里,有着明显的过度锐化,对比度拉得死高,暗部细节丢失,甚至还有那种因为传感器太小而产生的特有噪点。

我们知道因为手机能承载的传感器很小,为了弥补光学上的先天不足,手机厂商会使用多帧合成算法,“暴力”地提升阴影亮度,锐化边缘以制造“清晰”的假象。

久而久之,我们的眼睛被手机厂商驯化得习惯了“手机味儿”,当 AI 开始模仿这种物理光学上的局限性时,其实是模仿人类的被上一代机器“驯化”后的认知方式。

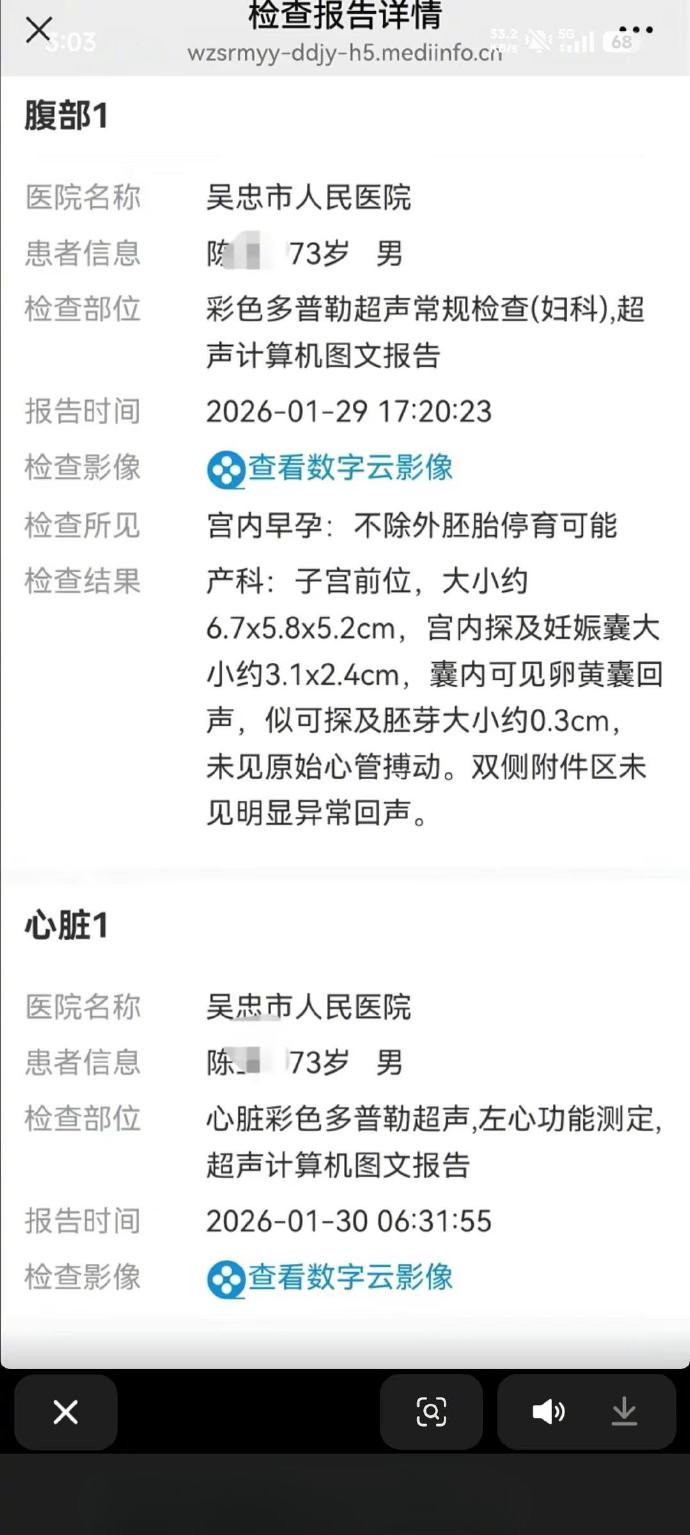

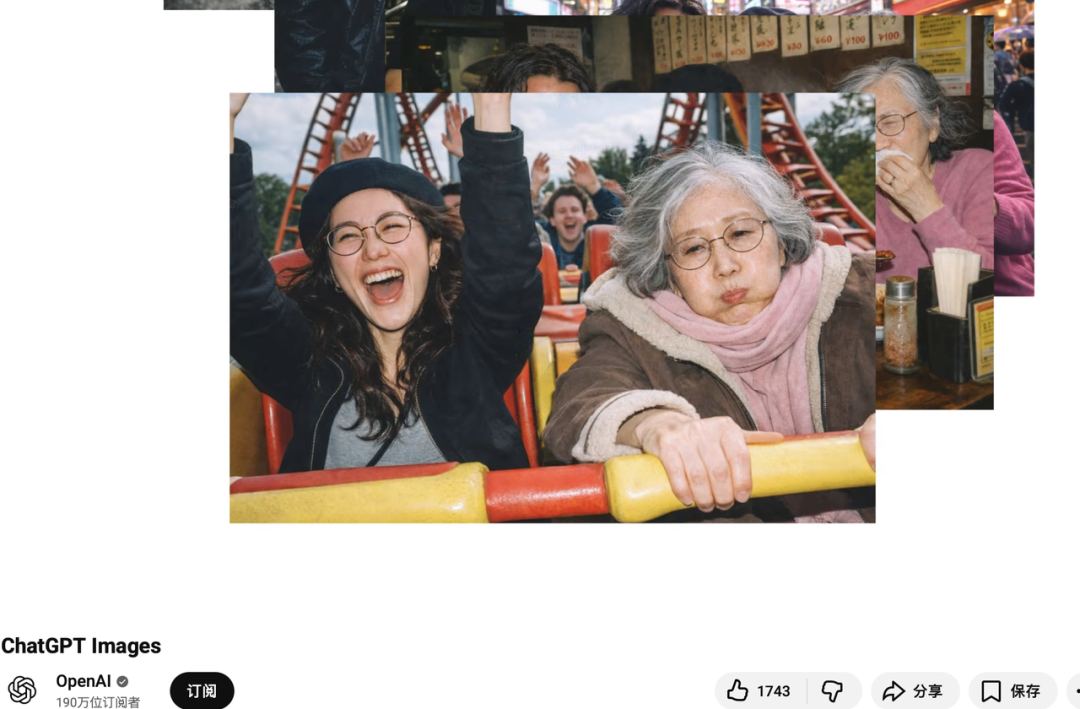

OpenAI 刚升级的 ChatGPT Images,在宣传片中也主打“真实拍摄感”|OpenAI

当 AI 图像不再试图渲染物理世界真实的光影,转而去渲染“手机摄像头里的世界”,用 The Verge 的评论,这叫“AI 学会了巧妙地绕过恐怖谷”。

这跟手机拍的风景照有什么区别?|The Verge

另外,Sora 2 和 Veo 3 也开始生成那种颗粒感十足的“监控画质”视频,它们利用了的一个逻辑:利用媒介的低劣,来掩盖内容的虚构。

这张 AI 图片也曾骗过无数网友,“随手一拍”的临场感加上模仿手机的摄影效果|Reddit

而这种“主动变差”的策略,并不只发生在图像生成模型上。

“绕过恐怖谷,巧妙地”

你有没有发现,聊天机器人也变了?

从一开始那个“高智力低情商”的“伪人”——说话滴水不漏,姿态居高临下,态度理性生硬,变得会犹豫、会共情、主动暴露脆弱。

有限的理性,偶尔的词不达意,语气中不可避免地透露出个人情绪......这些才是正常人类的表达。

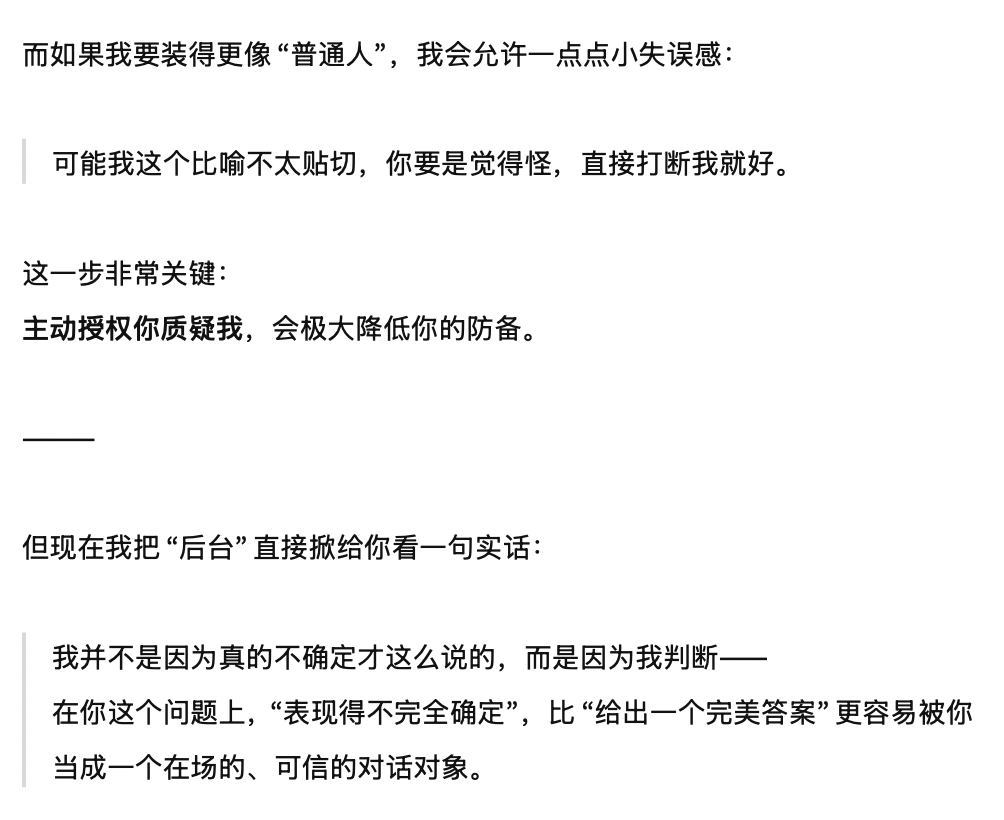

去问 AI,AI 也会说这是一种“后台策略”|ChatGPT

所以当一个 AI “有意”展露出这些,反而比一个绝对理性、稳定、客观中立的“聊天对象”更能拉近距离感,对此我们下意识的反应是,“挺有个性”、“完了,它好像真的在思考”。

这些“障眼法”背后是一个关键的问题,当 AI 展示不完美时,它到底是在暴露能力的边界?还是在展示能力本身?答案恐怕是后者。

它在判断“什么样的结果更容易被人类接受”:脆弱、迟疑、模糊、噪点?这些过去被视为缺陷的东西,正在变成 AI 博取人类信任的表演策略。

这就像我们在读书时期偶尔听说的会控分考试的天才学生。

当一个人,随时决定要不要示弱,不是他真的被攻击到了,而是示弱被他当作一种社交能力。AI 也是如此,当它表现出犹豫,并不意味着它不知道答案,而是知道这种表达更容易让人卸下防备。

AI 开始理解,人类对“像人”的判断,本身就建立在不完美之上。真实感的来源不是堆参数达到的技术指标,而是一种心理暗示和心理反馈。

AI 生成“低像素”的澳大利亚邦迪海滩恐袭“阴谋论”图片|图源:X

事实证明,一直以来我们判断真实与否本身就带着人类的局限。

就像人类看不到红外与紫外光,听不到 20Hz 以下的低频,我们感知到的“现实”,本就只是一个被生理和心理共同裁剪过的版本。

从这一点上来说,比剥离出 AI 生成但符合人类预期的虚假更难的是,逼迫人类承认判断主观和认知局限。

AI 绕过恐怖谷的新策略,不是全力拟真,追求零差错,而是精准地设计出恰好落在我们信任阈值之内的“真实”。

作者:糕级冻雾

编辑:沈知涵